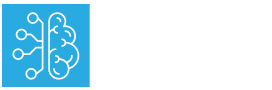

Tras el sorprendente lanzamiento del lenguaje GPT-3 el año pasado, OpenAI ha vuelto a maravillar al mundo con una nueva inteligencia artificial. Se trata de DALL-E, una tecnología que pueden encontrar asociaciones entre conceptos textuales y visuales. Es decir, que tiene la capacidad de producir imágenes a partir de indicaciones textuales.

¿Qué quiere decir esto? DALL-E puede crear imágenes a partir de las referencias dadas, sin importar lo poco realistas o extrañas que sean. No se trata de editar o modificar fotografías, sino de crear imágenes, que pueden ser tan variadas como «sillón en forma de aguacate»; «una nuez partida a la mitad»; «una tetera con las letras GPT»; o «un emoji de un pingüino bebé que viste un sombrero azul, guantes rojos y pantalones amarillos». Y no crea una sola imagen, sino varias imágenes con diferentes variaciones:

OpenAI es una de las empresas de inteligencia artificial con más reconocimiento a nivel mundial. En mayo de 2020 lanzó GPT-3, la tercera versión de su modelo de lenguaje que analiza textos, datos, instrucciones o preguntas dadas para ofrecer predicciones de palabras o realizar acciones. Este lenguaje se basa en 67 mil millones de libros públicos y documentos científicos disponibles en la web hasta toda Wikipedia y otras 19 mil millones de páginas web.

Aunque la base de DALL-E es menor, le permite crear nuevos conceptos. Y si bien las imágenes no tienen la calidad de una fotografía real, se pueden ver bastante definidas y algunas parecen absolutamente reales.

¿Cómo funciona DALL-E?

Esta red es un sistema de inteligencia artificial multimodal. Para ello, utiliza una versión de GPT-3 de 12 mil millones de parámetros, que le permite crear diferentes versiones de lo que se pide. Lo más sorprendente es que no solo crea imágenes de ideas existentes, sino que también puede crear conceptos inexistentes. Por ejemplo, puede crear versiones antropomorfizadas de animales y objetos.

OpenAI escribió:

Hemos descubierto que [DALL-E] tiene un conjunto diverso de capacidades, incluida la creación de versiones antropomorfizadas de animales y objetos, la combinación de conceptos no relacionados de manera plausible, la representación de texto y la aplicación de transformaciones a imágenes existentes.

Además, según el equipo de OpenAI, DALL-E puede sustituir los detalles que no se indican explícitamente antes de arrojar las imágenes. Esta es una de sus grandes diferencias frente a los motores de renderizado 3D.

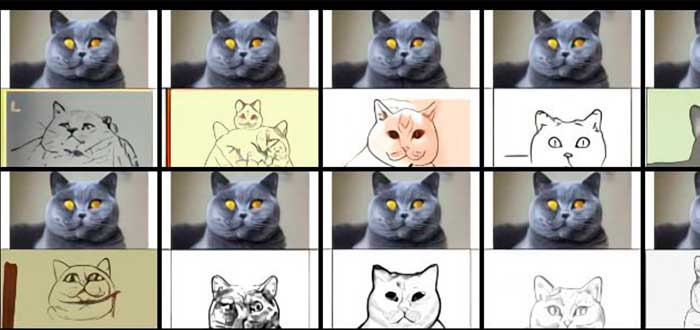

DALL-E también puede combinar instrucciones de texto y una indicación visual. Puedes alimentarlo con una imagen y solicitar una modificación. Por ejemplo, podría mostrarle a DALL-E un gato y pedirle un dibujo, o que le agregue gafas de sol. El programa lo haría sin problema.

Los investigadores explican que el resultado de estas creaciones depende de la descripción que se le aporte a la red neuronal: «A medida que se introducen más objetos, DALL-E tiende a confundir las asociaciones entre los objetos y sus colores, y la tasa de éxito disminuye drásticamente».

Entre las limitaciones del programa también destaca que puede confundirse entre objetos y asociaciones. Es decir, DALL-E puede controlar múltiples objetos y sus atributos, junto con sus relaciones espaciales. No obstante, puede confundirse por los objetos y sus asociaciones. En escenarios desafiantes esto es frágil al reformular los títulos.

Recomendado: Tipos de Inteligencia Artificial | Débil, general y súper-inteligencia