Aunque la computación cuántica ha dado grandes pasos en los últimos años, todavía tiene que resolver algunos problemas antes de convertirse en una tecnología extendida en el mundo. Entre ellos, destaca el tener mejores cúbits, tener control preciso de las operaciones y, sobre todo, la corrección de errores.

De hecho, este último elemento es una de las grandes barreras de la tecnología. Dados los delicados estados cuánticos, los ordenadores cuánticos son, en realidad, muy propensos a errores. ¿A qué se debe esto? A su funcionamiento interno.

La computación cuántica funciona gracias a los cúbits, que actúan a través de los fenómenos de la mecánica cuántica: la superposición y el entrelazamiento. Gracias a esto no tienen que ser «0» o «1», sino que pueden ser ambos o existir en sus estados intermedios. El problema es que estos estados cuánticos se ven perturbados con facilidad por el ruido, el calor o los campos electromagnéticos.

Como consecuencia, se pueden introducir errores en los cálculos. De hecho, las plataformas cuánticas de vanguardia actuales suelen tener tasas de error cercanas a 10^-3 (o uno entre mil), pero muchas aplicaciones prácticas requieren tasas de error tan bajas como 10^-15.

Además, la computación cuántica no permite una solución tan práctica como «revisar los errores». Al poder existir en valores de «0» y «1» simultáneamente, cualquier intento de medir el cúbit hace que su estado colapse a «0» o «1», y destruye cualquier cálculo.

Este planteamiento tenía a los científicos en una encrucijada: el potencial de la tecnología cuántica es increíble. No obstante, no pueden ponerlo en marcha a gran escala a menos que se pueda corregir esta tendencia al error. La encrucijada era insalvable hasta ahora, pues, recientemente, Google parece haber hallado la solución.

Tabla de contenidos

Reducir los errores en la computación cuántica

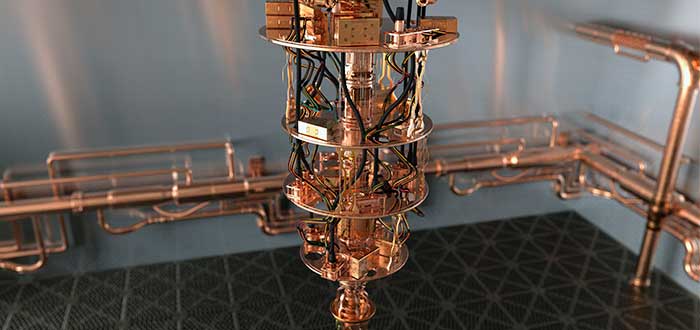

En los últimos días, Google publicó un artículo en la revista Nature en el que describen un nuevo enfoque para corregir los errores y escalarlos a ordenadores cuánticos más grandes. La compañía tecnológica demostró que la supresión exponencial de errores es posible y los códigos de estabilización son la clave.

Estos códigos, en realidad, ya han sido parte de la estrategia de las compañías para solucionar el problema. Consiste en distribuir la información cuántica a través de muchos cúbits de manera que los errores se pueden detectar y corregir. Su objetivo es crear un cúbit lógico que vincule diversos cúbits físicos y compruebe si hay errores.

Para ello se recurre al fenómeno cuántico de entrelazamiento, que vincula el estado de dos o más cúbits. Al entrelazarlos se genera un «cúbit lógico» que codifica una única superposición. Para detectar estos errores, los cúbits de datos —que codifican la superposición— se entrelazan con los cúbits de medida. Al medir estos cúbits, se puede determinar si los cúbits de datos han experimentado un error, qué tipo de error es y corregirlo. Todo ello sin leer realmente su estado y alterar la superposición del cúbit lógico.

La idea no es nueva, pero ha sido difícil demostrar su efectividad. Sin embargo, Google lo ha logrado. Los experimentos los hizo en su procesador cuántico Sycamore de 52 cúbits y permitieron comprobar que el método debería escalar para ayudar a construir las computadoras cuánticas tolerantes a fallas.

- Artículo relacionado: Qué es el internet cuántico y cómo revolucionará las futuras comunicaciones

Google, más cerca del éxito

En la publicación en Nature, los investigadores de Google detallaron su método. Ellos intentaron dos tipos de códigos. El primero creó una larga cadena de cúbits de datos alternos y cúbits de medida. El segundo creó una celosía 2D de dos tipos diferentes.

El primer método

El primer método se conoce como código de repetición. En él, los cúbits se alternan entre cúbits de datos y cúbits de medida (encargados de detectar errores en los otros cúbits). Estos se organizaron en una cadena unidimensional; es decir, cada cúbit debía tener dos vecinos como máximo.

Los investigadores encontraron que entre más cúbits tuviera el código de repetición, se lograba una exponencial reducción en la tasa de errores. Así, se logró disminuir la cantidad de errores por ronda de correcciones hasta más de cien veces cuando escalaron el número de cúbits de 5 a 21. Esto sugiere, a su vez, que la cantidad de tiempo que se puede mantener un cúbit lógico debería aumentar a medida que crece el número de cúbits disponibles.

Sin embargo, este código de repetición «se limitó a observar errores cuánticos en una sola dirección, pero los errores pueden ocurrir en múltiples direcciones», explicó el coautor del estudio Kevin Satzinger, científico investigador de Google.

- Te recomendamos: BMW apuesta por la computación cuántica | Esto es lo que busca en alianza con Honeywell

El segundo método

Teniendo en cuenta lo anterior, los investigadores también experimentaron con un código estabilizador llamado código de superficie. Los científicos creen que este será el sistema que ayudará a corregir los errores en computadores cuánticos de gran escala. En este caso, los cúbits de Sycamore se arreglaron en un patrón bidimensional de cúbits de datos y medidas para detectar errores.

Así, encontraron que la versión más simple del código de superficie de este tipo —que utiliza una cuadrícula de dos por dos de cúbits de datos y tres cúbits de medida— funcionó con éxito. No obstante, es más difícil asignar las detecciones a las correcciones. Además, esta disposición también es más susceptible a errores. Por lo tanto, el rendimiento de los cúbits físicos tendrá que mejorar antes de que este enfoque pueda demostrar la supresión de errores.

A pesar de que todavía queda camino por recorrer, los investigadores creen que se acercan al umbral donde es posible la supresión de errores. El estudio concluye afirmando que la computación cuántica práctica probablemente requerirá 1 000 cúbits físicos por cada cúbit lógico. Por lo tanto, el hardware subyacente aún tiene un largo camino por recorrer.

- Te podría interesar:

- Inteligencia artificial y computación cuántica | ¿Qué esperar de esta potente alianza?

- Hacia una IA cuántica | Nuevo memristor cuántico podría integrar ambos mundos

- Criptografía poscuántica | Qué es y por qué es necesaria

- Teletransportación cuántica | Avances de un posible futuro cuántico

- 14 tecnologías del futuro | Las innovaciones que cambiarán el mundo

- Nueva tecnología de Google busca que los ordenadores puedan leer el lenguaje corporal