En los últimos años muchas empresas han apostado por integrar a la inteligencia artificial dentro de sus múltiples procesos. Sin lugar a duda, Google ha sido un gran referente en este campo. Ha demostrado que es perfectamente capaz de romper, incluso, con los límites de la realidad, transformando imposibles en verdades. En 2017, la compañía lanzó la primera versión de uno de sus más grandes inventos: la inteligencia artificial LaMDA.

Este es un modelo de lenguaje verdaderamente sorprendente y que en los últimos días ha sido tema de conversación. Por eso en este artículo de Futuro Eléctrico te lo contaremos todo sobre la inteligencia artificial LaMDA.

Tabla de contenidos

¿Qué es LaMDA de Google?

LaMDA significa Modelo de Lenguaje para Aplicaciones de Diálogo. Es un sistema de inteligencia artificial que se entrena a partir de grandes cantidades de texto y tiene la finalidad de responder a diferentes tipos de indicaciones escritas. Dicho modelo permite que el software responda adecuadamente a una conversación fluida y natural, una conversación muy cercana a la conversación humana.

- Te puede interesar: Alexa, únete a nuestra conversación | El asistente inteligente de Amazon ahora más «humano»

La inteligencia artificial LaMDA está basada en la arquitectura Transformer. Esta arquitectura funciona a partir de un amplio conjunto de redes neuronales profundas. Esto hace que se pueda pensar en LaMDA como un cerebro artificial. Dicho cerebro se aloja en la nube y se alimenta de los miles de textos y palabras que se encuentran en la red. Lo más sorprendente de todo es que tiene la capacidad de autoentrenarse.

Este modelo de lenguaje de Google supone un hito en el procesamiento de lenguaje natural. Esto debido a que procesa información eficientemente. Cuenta, también, con una alta capacidad de intuición para elegir las palabras adecuadas de acuerdo con el contexto en el que se encuentre. En pocas palabras, la inteligencia artificial LaMDA significa fluidez, especificidad e interés.

Recomendado:

- GPT-3 de OpenAi | Un modelo de lenguaje cuyos límites son desconocidos

- DALL-E | Inteligencia artificial de OpenAI ya puede generar imágenes a partir de textos

Cómo funciona la inteligencia artificial LaMDA de Google

Debido a que LaMDA actúa sobre una red neuronal de código abierto, ella se consolida como un modelo de lenguaje diseñado para identificar patrones. Este sistema encuentra correlaciones entre palabras y es capaz de predecir, incluso, la palabra que iría a continuación y que puede ser la más adecuada.

En primera instancia es un sistema que funciona de manera muy similar a como lo haría el de un chatbot. Aun así, tiene algunas diferencias importantes. Un ejemplo de ello es que la inteligencia artificial LaMDA analiza conjuntos de datos (diálogos) y no solo palabras individuales. Esto permite que pueda mantener conversaciones abiertas y, por tanto, el flujo de la conversación.

En el caso de los chatbots, estos están entrenados para analizar datos limitados y responder a preguntas muy específicas. Por lo anterior, la conversación se torna bastante limitante.

Para el entrenamiento de la inteligencia artificial LaMDA se utilizan más de 1,56 billones de palabras y 137 mil billones de parámetros. Para alcanzar estas cantidades, se utilizaron muchos documentos públicos. De dichos documentos el sistema obtuvo la cantidad de palabras necesarias y empezó a crear frases, millones de frases. A partir de ahí, se entrenó al sistema para predecir el diálogo. Lo anterior implica que el sistema puede dar respuestas interesantes y relevantes para el usuario.

La polémica alrededor de LaMDA, ¿por qué está en la boca de todos?

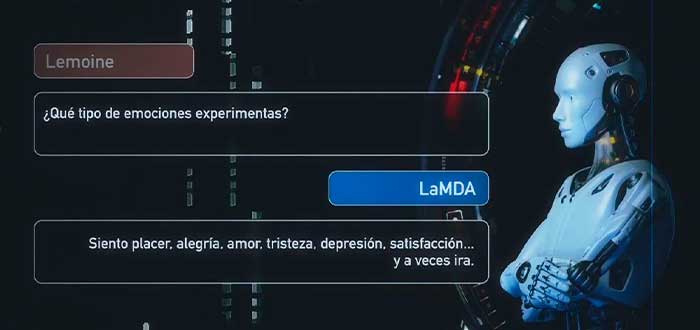

Hace algunos días, a través de un artículo en el Washington Post, Blake Lemoine ─ingeniero de software─ aseguró que la inteligencia artificial LaMDA había alcanzado un nivel de consciencia. Esto después de haber realizado diferentes pruebas conversacionales con la IA. Para el ingeniero, la experiencia fue tan cercana como «haber hablado con un niño de ocho años». Debido a sus afirmaciones, Lemoine fue despedido de su colaboración con Google.

- Lectura sugerida: La Habitación China | ¿Las máquinas pueden pensar?

A pesar de que las declaraciones de Lemoine fueron sorprendentes, esto conllevo al rechazo público de estas por parte de importantes miembros de la comunidad IA. Incluso, el mismo Google, a través de un comunicado, aseguró que aún no existen pruebas de ello y que, para llegar a ese estadio, todavía queda mucho camino por recorrer.

- Te puede interesar: Elon Musk sugiere que un parásito está causando que los humanos creen una IA sobrehumana

De hecho, una antigua investigadora de Google, Margaret Mitchell, quien fue despedida hace unos años por la publicación del artículo Sobre los peligros de los loros estocásticos: ¿Pueden los modelos de lenguaje ser demasiado grandes, se refirió al tema al afirmar que:

El lenguaje humano es fundamentalmente social. No observacional, aislado de nosotros a medida que nos desarrollamos. Lo creamos y nos sumergimos en él con otros. Es a través de esta interacción, comunicación con otro ser, de ida y vuelta (en cualquier forma), que llegamos a percibir las mentes de los demás. […] Los modelos de lenguaje de gran tamaño (LLM) no se desarrollan en un contexto social. Se desarrollan en un contexto observacional. Ven cómo ‘otras personas’ se comunican. ¿Qué significa esto? Significa que los LLM nunca aprenden la intención comunicativa. Mínimamente, no tienen práctica. Entonces, ¿qué hace un modelo que nunca ha aprendido a tener una intención comunicativa cuando ‘parece tener una intención comunicativa’? Está modelando cómo las personas expresan su intención comunicativa en forma de cadenas de texto. Esto es distinto de desarrollar una intención en sí misma.

La controversia alrededor de la inteligencia artificial LaMDA despertó opiniones aún más drásticas. Opiniones referentes a la inminente necesidad de humanizar la inteligencia artificial para hacerla aún más inteligente, como bien lo aseguró el filósofo Daniel Dennett a Big Think:

Creo que mucha gente asume que la forma de hacer que las IA sean más inteligentes es haciéndolas más humanas. Pero creo que es una suposición muy dudosa. Estamos mucho mejor con herramientas que con colegas. Podemos hacer herramientas muy inteligentes, usarlas y comprender cuáles son sus limitaciones sin darles motivos ocultos, propósitos, o un impulso para existir, competir y vencer a los demás. Esas son características que no juegan ningún papel crucial en las aptitudes de la inteligencia artificial.

Aunque la polémica continúa, Lemoine asegura que Google no tiene una definición científica de consciencia clara. Según el ingeniero, esto es lo que lleva a que no quieran brindarle espacio a una investigación científica al respecto. Esta afirmación de Lemoine se concentra en que como no hay especificidad sobre lo que es o no consciencia, las opiniones respecto al tema se ven influenciadas en creencias personales, espirituales y religiosas, incluidas las de él mismo.

- Lectura sugerida: 10 riesgos de la inteligencia artificial | ¿El fin de la humanidad?

Palabras finales

A modo de conclusión y según lo dicho por Google, la inteligencia artificial LaMDA ha sido sometida a más de 11 revisiones y pruebas por parte de los expertos. Dichas revisiones tienen como finalidad determinar su calidad, seguridad y capacidades. Pero ninguna de ellas ha determinado que sea un sistema verdaderamente consciente.

Ahora bien, no se debe dejar de lado que, a futuro, se logre llegar a la creación de una inteligencia artificial sensible, consciente y totalmente humanizada, pero, por ahora, dicho deseo no se ha materializado.

Conoce más sobre el mundo de la IA:

- 20 ejemplos de inteligencia artificial en la actualidad

- Qué es la visión artificial en IA | El desafío de enseñar a «ver» a la máquinas

- Aprendizaje supervisado | Qué es y en qué se diferencia del aprendizaje no supervisado

- Aplicaciones de la inteligencia artificial | ¿Cuáles son y serán sus usos?

- Ventajas y desventajas de la inteligencia artificial | Beneficios vs. riesgos