La tecnología ha crecido enormemente en la última década, a tal punto que campos como la inteligencia artificial (IA) tiene aplicaciones en varias áreas con resultados satisfactorios y grandes beneficios económicos. Sin embargo, hay un tema que está ensombreciendo a la IA: la discriminación que se ha podido observar en varias ocasiones. Se conoce como bias en inteligencia artificial y parece ser un error que no ha podido resolverse.

Situaciones como la raza, orientación sexual, condiciones físicas, etcétera, podría ser determinante para sufrir los sesgos en inteligencia artificial. Este hecho podría ser una representación de cómo, a pesar que la humanidad ha avanzado, siguen existiendo situaciones de injusticia y desigualdad en nuestra sociedad actual. ¿Quieres saber más? Sigue leyendo este artículo de Futuro Eléctrico.

Tabla de contenidos

¿Qué es bias en inteligencia artificial?

El bias en inteligencia artificial es un tipo de error sistemático que puede favorecer ciertas respuestas frente a otras. El sesgo en inteligencia artificial ha surgido con la implementación de este tipo de tecnología, y a pesar de que ha habido esfuerzos por eliminarlos, parece ser insuficiente. Aparece en el momento de interpretar los datos almacenados de las personas y en dependencia del funcionamiento de los algoritmos.

No obstante, el tema se ha puesto en análisis con un mayor énfasis desde el estreno del documental Coded Bias (Sesgo codificado) de Netflix. Con toda la información disponible hasta el momento, se puede afirmar que el bias en inteligencia artificial no es una simple creencia, sino que se trata de una realidad indubitable.

¿Quiénes son responsables del bias en IA?

¿Pero por qué una tecnología que, en teoría, debería ser imparcial e inclusiva termina siendo discriminatoria? Pues,ç porque los desarrolladores siguen teniendo prejuicios (conscientes o no) que terminan viéndose reflejados, en este caso, en la inteligencia artificial.

Te puede interesar:

- La evolución de la IA | La clave para lograr una inteligencia superior a la humana según Google

- Inteligencia aumentada o cómo la IA puede hacer a los humanos más inteligentes

Por eso las personales detrás de la inteligencia artificial han sido señaladas como las responsables de que sigan existiendo sesgos en IA debido a que procesan toda la información y, en gran medida, determinan el comportamiento de la inteligencia artificial. Son este grupo de humanos los que también le dan importancia a un grupo de datos por encima de otros, los estructuran y clasifican con base a su utilidad.

Al respecto, Fei-Fei Li, científica jefe de inteligencia artificial en machine learning en Google Cloud y directora del Laboratorio de Inteligencia Artificial de la Universidad de Stanford, afirmó que:

[La inteligencia artificial] va a guiar los valores que importan en nuestras vidas, como la ética, los prejuicios, la justicia o el acceso. Si no tenemos tecnólogos representativos de la humanidad sentados a la mesa, la tecnología inevitablemente no va a representarnos a todos.

Tipos de sesgos en IA

Existen diferentes tipos de sesgos en inteligencia artificial, los más comunes son los siguientes:

- Measurement bias o sesgo de medición: Cuando la información recopilada para su uso como variable de estudio es inexacta. También aparece cuando los datos de entrenamiento son diferentes a los recolectados en el mundo real.

- Exclusion bias o sesgo de muestreo: Se omiten datos creyendo que no son de interés.

- Sample bias: Algunos individuos tienen una probabilidad de muestreo menor o mayor que otros, del mismo modo, no reflejan la realidad del ambiente.

- Observer bias o efecto de expectativa: El sesgo cognitivo de un investigador hace que influya inconscientemente en su trabajo.

- Association bias: Es de tipo social, refuerzan o multiplican un sesgo cultural.

- Racial bias: Se favorece a un grupo demográfico. Por ejemplo, los hombres blanco cisgéneros tienen mayor probabilidad de ser detectados y favorecidos por los sistemas de IA.

Para ti: Ventajas y desventajas de la inteligencia artificial | Beneficios vs. riesgos

Estadísticas sobre los sesgos en inteligencia artificial

Discriminación en la publicidad de Facebook

Con respecto a este tema, distintos grupos de expertos han realizado estudios que sirven para comprender el panorama completo del bias en inteligencia artificial. De hecho, un estudio de Propublica (2016) dio pruebas fehacientes de la existencia de usos discriminatorios del modelo de negocios de publicidad selectiva de Facebook que usan inteligencia artificial. Según el reporte, algunas personas no tienen acceso a publicidad sobre viviendas por ser inmigrantes o por la clase social que tienen, según lo distingue el algoritmo.

Esto en lo absoluto tiene algo que ver con mostrar publicidad basada en los intereses de la persona. En realidad, están condicionando que si eres extranjero no tienes posibilidades de adquirir una vivienda en otro país, aunque estés legal. Así también excluyeron a personas por su identificación sexual y hasta por su apariencia física.

Te puede interesar:

- Metaverso de Facebook | Pros y contras de los nuevos planes de Zuckerberg

- Facebook podría crear una pulsera para leer la mente | El siguiente nivel de la realidad aumentada

- Una IA que recuerde por ti | La nueva tecnología de Facebook

- Ego4D | Facebook podría crear una IA que vea, escuche y recuerde lo que hacemos

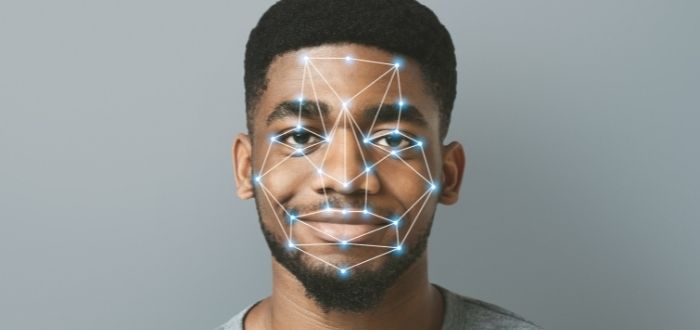

Discriminación por color de piel

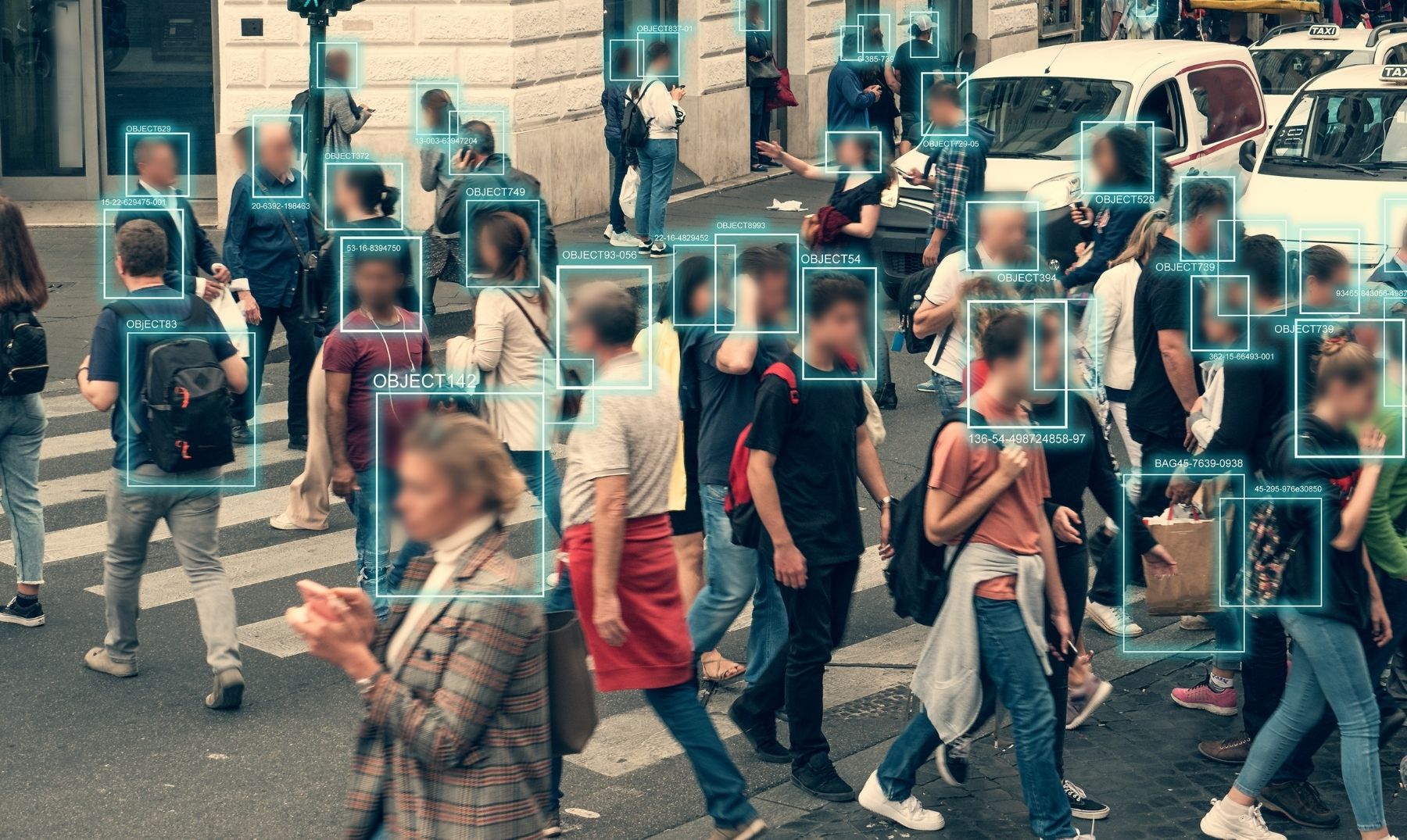

También la totalidad de los algoritmos analizados discriminan de modo bastante notorio contra las personas de color, de acuerdo a lo expresado por el Instituto Nacional de Estándares y Tecnología (NIST), organismo perteneciente al Gobierno de Estados Unidos. Una persona de color tiene cien veces más probabilidades de ser identificada de modo incorrecto. Este problema afecta principalmente a individuos nativos americanos, afroamericanos y asiáticos.

- Lectura sugerida: De nuevo sobre los sesgos: crean una IA para dar juicios éticos y resulta ser racista

Bias por género

Tras conocerse que los sistemas de reconocimiento facial comerciales identificaban mucho mejor a los hombres blancos, Hanna Wallach, investigadora en Microsoft, ha comentado:

Esos sistemas reproducirán todos los sesgos y desigualdades presentes en el mundo real a menos que la gente tome estos problemas en serio y trabaje para detectarlos y mitigarlos.

En el artículo «AI is Sexist and Racist. It’s Time to Make it Fair» de James Zou y Londa Schiebinger se muestran ejemplos de que sistemas de inteligencia artificial arrojan resultado de mujeres occidentales cuando se hace búsquedas con los términos «novia», «vestido» o «boda» o en el caso del atuendo típico de la cultura de la India que aparece bajo las palabras «arte de performance» o «disfraz». Este término sirve para reafirmar, lo que en opinión de los escritores es la IA: sexista y racista.

Ejemplos de cómo afecta el bias en inteligencia artificial

Los bias en inteligencia artificial se pueden encontrar en los traductores de texto, en las herramientas de reclutamiento, en aplicaciones relacionadas a la justicia penal, sistemas de reconocimiento de voz y discurso, aplicaciones de salud y sistemas de reconocimiento facial, por ejemplo. Por eso casos donde los sesgos en inteligencia artificial se ponen de manifiesto hay muchos.

El más notorio es el caso de LinkedIn, cuando en 2016 se descubrió que su algoritmo recomendaba empleos mejor remunerados a hombres y los que ofrecían salarios más bajos se anunciaba hacia mujeres. Esto es una representación de la brecha por géneros que existe en el mundo laboral, donde los puestos con mayor salario son ocupados por hombres.

También Amazon ha tenido malas experiencias con el bias en inteligencia artificial. En 2014 la compañía intentó automatizar el proceso de selección de candidatos para puestos de empleo. Los sistemas de IA se basaron en datos de personas que trabajaron en la empresa durante los últimos 10 años. El problema es que decidió descartar la mayoría de currículums pertenecientes a mujeres. La discriminación por género fue tan grave que Amazon tuvo que cancelar el proyecto inmediatamente.

¿Google Translate es sexista? Este traductor automático, al igual que otros, asigna un género específico al traducir determinadas palabras. Por ejemplo, le asigna el género femenino a la palabra «nurse» y masculino a «doctor», haciendo que haya un claro bias en inteligencia artificial por género.

Recomendado:

- 20 ejemplos de inteligencia artificial en la actualidad

- 10 ejemplos de inteligencia artificial en la vida cotidiana

Como último ejemplo podemos mencionar el reciente documental Coded Bias. En él se muestra la historia de Joy Buolamwini, una científica informática que cuando desarrollaba aplicaciones en un laboratorio del departamento de ciencia de la computación de su universidad descubrió una terrible realidad: su cara no era reconocida por un sistema de reconocimiento facial. En este documental, se busca que el uso de inteligencia artificial no perpetúe ni amplifique injusticias sociales.

- Te puede interesar: Inteligencia artificial y computación cuántica | ¿Qué esperar de esta potente alianza?

Empresas que luchan contra el bias en inteligencia artificial

De momento, son pocas las empresas que han tomado acciones para eliminar estas situaciones de racismo, clasismo y discriminación en general. Sin embargo, sí existen algunas que han tomado cartas en el asunto.

Al respecto, Telefónica se convirtió en una de las primeras compañías del mundo en fijar unos principios de aplicación de IA y de pautas éticas con las que pretenden contribuir a que el sesgo en inteligencia artificial desaparezca.

Por su parte, Google, tras un escándalo luego de que una persona en 2005 denunció que este servicio había etiquetado las fotos de él con un amigo de color como «gorilas», aseguró que trabajaría en soluciones a largo plazo. Dos años más tarde, borraron los términos relativos a gorilas y algunos otros primates del léxico del servicio. Pero esta acción resulta insuficiente y no resuelve el problema de fondo.

Por otro lado, Women in Machine Learning & Data Science, Women in AI y Women in Data Science son algunas organizaciones globales que pretenden, a través de la educación y jornadas de concientización, formar profesionales en tecnología que sean muchos más inclusivos con las minorías para tratar de frenar los sesgos en inteligencia artificial.

Palabras finales

La problemática del bias en inteligencia artificial se resolverá cuando realmente haya diversidad de datos. Se necesita que se tome en cuenta a las minorías y que definitivamente no haya diferencias por géneros, condición social, situación económica, entre otras. También es importante que las personas sean más incluyentes, dejando de lado sus propios prejuicios hacia terceras personas para poder tener una sociedad, tanto en el mundo real como en el virtual, más equitativa.

Te sugerimos leer otros artículos sobre inteligencia artificial:

- Tipos de Inteligencia Artificial | Débil, general y súper-inteligencia

- Peligros de la Inteligencia Artificial | ¿El fin de la Humanidad?

- ¿Puede la inteligencia artificial manipular a los humanos? | Reciente estudio así lo demuestra

- Inteligencia artificial emocional | ¿Máquinas con emociones artificiales?

- Las 15 mejores películas de inteligencia artificial

- LaMDA | ¿La inteligencia artificial de Google tiene consciencia?