Cuando imaginamos a un hacker la imagen que llega a nuestra mente es de una persona, usualmente joven, en un cuarto medianamente oscuro, rodeada de computadores y tecleando a la velocidad de la luz. Sin embargo, esta imagen algún día comenzará a ser obsoleta. El mundo está cambiando y algunos de los conceptos que hoy en día conocemos también lo harán.

El concepto de hacker será uno de aquellos que se transformarán. En los próximos años, los hackers dejarán de ser humanos y algo mucho más poderoso y rápido lo reemplazará: la inteligencia artificial. No obstante, este proceso no solo significa reemplazar a un hacker humano por uno digital, sino un futuro de sistemas de IA hackeando a otros sistemas de IA.

Esta situación es planteada por Bruce Schneier, llamado el «gurú de la seguridad» por The Economist, en su ensayo The coming AI hackers. En este documento, Schneier plantea que «nos arriesgamos a un futuro en que los sistemas de inteligencia artificial piratean a otros sistemas de inteligencia artificial, y los humanos son poco más que daños colaterales». Y, para ello, no se necesitan sistemas maliciosos de IA, como Skynet de Terminator.

Los hackeos de los que habla Schneier tienen un sentido más amplio; implica mucho más que sistemas y software: reúne a sistemas sociales, políticos, económicos y a nosotros mismos. Y todo esto a una velocidad, escala y alcance sin precedentes. ¿A qué se refiere Schneier? ¿Cuáles son las implicaciones que plantea? En Futuro Eléctrico te lo explicamos.

Tabla de contenidos

Algunos conceptos clave

Vulnerabilidades y bugs

Para poder explicar el panorama que expone Bruce Schneier es importante aclarar unos conceptos clave. Entre ellos, encontramos el término bugs en computación, que se traduce como errores o fallas de un programa informático. Y este concepto abre la puerta a las vulnerabilidades.

Todos los software de computación tienen defectos, los bugs. Son errores en programación, especificación o en algún momento de la creación de software. Pueden aparecer tanto en tu celular como en tu computador o, incluso, en el internet de las cosas. Los fallos suelen permanecer ocultos, por lo que todos estos dispositivos funcionan normalmente, aunque el bug esté ahí.

Lectura sugerida: Aplicaciones del internet de las cosas | ¿Cuáles son sus usos?

Ahora, algunos de estos fallos se pueden traducir en errores de seguridad; es decir, vulnerabilidades. Hablamos de fallos que un atacante puede activar para poder sacar provecho de cierta condición. No todos los bugs son vulnerabilidades, porque no a todos se les puede sacar provecho. Algunos solo pueden generar resultados inesperados.

Cabe destacar que estos errores o fallos y vulnerabilidades no solo se presentan en los sistemas informáticos. Los demás sistemas también son susceptibles a tenerlos. Un gran ejemplo son los códigos de impuestos. Algunos tienen problemas en cómo se escriben las leyes, otros en cómo pueden ser interpretados, otros pueden generar omisiones o no prever cómo interactúan diferentes segmentos de la misma ley. Todos estos fallos generan vulnerabilidades que pueden ser aprovechados por los hackers para evadir el pago de sus impuestos.

Inteligencia artificial

También es importante hacer una diferenciación entre los tipos de inteligencia artificial. Los científicos distinguen tres tipos: la IA específica o débil, la IA general y la superinteligencia. La primera se ha diseñado para desarrollar una tarea específica. Los sistemas de conducción automática son un ejemplo. Son IA diseñadas para saber todo lo posible sobre un tema específico y tomar decisiones frente al mismo. La IA general es la que solemos ver en las películas y solemos temer. Se refiere a máquinas que pueden realizar cualquier actividad intelectual que los seres humanos hagan.

Y, finalmente, la superinteligencia que es una inteligencia que pueda pensar, sentir y actuar de manera general; por lo tanto, es aquella que esperamos que supere nuestra inteligencia. Las investigaciones en este campo son menos avanzadas que en los anteriores, dado que requiere de mucha investigación el diseño de estos sistemas. Se espera que este campo no esté listo sino hasta dentro de algunas décadas.

En este artículo nos centraremos, al igual que Bruce Schneier, en la inteligencia artificial específica.

Te puede interesar: Aplicaciones de la inteligencia artificial | ¿Cuáles son y serán sus usos?

Hackear

Ponemos el concepto en cursiva por el debate etimológico que nos plantea la palabra. En sí, la palabra en español se traduce como piratear o introducirse de forma no autorizada en un sistema informático. Es una traducción que proviene de su uso en inglés; especialmente al referirnos a los espacios tecnológicos.

Sin embargo, en este artículo, al usar la palabra hackear nos vamos a remitir a la definición de hack en inglés, que tiene los siguientes dos significados:

- Una explotación inteligente e involuntaria de un sistema que subvierte las reglas o normas de ese sistema a expensas de alguna otra parte de ese sistema.

- Algo que permite un sistema, pero que sus diseñadores no han planeado ni anticipado.

De esta forma, podemos ver que hack no es hacer trampa; cometer acciones delictivas contra la propiedad, como dice la definición de piratear; o el robo o destrucción de los bienes de alguien, como la definición de piratería en español. Hack, por el contrario, es seguir las reglas, pero subvertir su intención inicial. Es decir, es «vencer al sistema».

Bajo esta idea, el término hack no se limita a los computadores y sistemas informáticos, aunque ciertamente los incluye. El término también alude a todo sistema de reglas, como el código de impuestos. Y este sistema de reglas está diseñado para obtener resultados específicos. Sin embargo, hack es perseguir otro resultado, inesperado y no planteado por los diseñadores del sistema, sin romper estas reglas.

En palabras de Schneier es «algo que beneficia al pirata informático de alguna manera a expensas de los usuarios a los que se supone que sirve el sistema».

¿Qué se puede hackear?

Hackeos humanos

Para comenzar conviene preguntarse ¿quién puede hackear? Y la respuesta es interesante: si bien la inteligencia artificial puede hackear, los humanos fuimos los primeros en hacerlo. De hecho, los humanos somos hackers naturales. Contar cartas en el Blackjack es un ejemplo, modificaciones en los autos de la Fórmula 1 que no están específicamente prohibidos es otro. Los abogados son un buen ejemplo de alguien que se dedica a hackear.

Entre otros ejemplos destacamos, por supuesto, la historia de las finanzas, que está llena de momentos en los que se aprovecharon los vacíos legales —lo que no está expresamente prohibido— para sacarle provecho. En la historia reciente, Uber y Airbnb son un excelente ejemplo de compañías que han hackeado las regulaciones gubernamentales.

¿Sabes qué más han aprendido a hackear las personas? A otras personas y sus cerebros. Las redes sociales hackean nuestra atención y nos persuaden en cuanto comportamiento y actitudes. Lo mismo hace la publicidad. La desinformación, por su parte, hackea nuestra visión de la realidad. Y hay muchos ejemplos más…

Luego llegamos a la computación, que también puede ser hackeada junto a todo lo que se ha procesado en ella. Es decir, los computadores, lo que se ha computarizado, como las finanzas, impuestos, información confidencial y más.

Lectura sugerida: Biometría | Cuando tu cuerpo es tu método de autenticación

La era de la computarización

La IA está en la capacidad de hackear todo lo que los humanos hemos aprendido a hackear a lo largo de nuestra historia. La diferencia es que puede hacerlo a una escala y velocidad más grande de lo que nos sería posible nunca. Schneier estipula en su ensayo:

La velocidad de la computadora modifica la naturaleza de los ataques. Toma un concepto simple, como el comercio de acciones, y automatícelo. Se convierte en algo diferente. Puede hacer lo mismo que siempre hizo, pero lo hace a una velocidad sobrehumana. Un ejemplo es el comercio de alta frecuencia, algo no intencionado y no anticipado por quienes diseñaron los primeros mercados.

Ahora bien, cabe resaltar que entre más complejo sea un sistema de reglas, más vulnerable es. Esto se debe a que abre la puerta a consecuencias no anticipadas ni planteadas. Si los sistemas se rigen por reglas sociales flexibles, son más vulnerables que las reglas rígidas porque son más abiertos a la interpretación. Por lo tanto, tienen nuevos vacíos.

Para la inteligencia artificial y los computadores esto tendrá muchísima importancia, como ya se verá, sobre todo al abordar cómo hackean todo tipo de sistemas.

Aspectos a considerar: relaciones entre los humanos y la IA

Existen numerosos estudios que hablan sobre cómo nos relacionamos con la inteligencia artificial y los robots. Unos estudios arrojan que si queremos relaciones empáticas con la inteligencia artificial, se necesitará un cuerpo robótico; otros nos explican cómo la IA puede manipular a los humanos; asimismo, se debate la capacidad de pensar de la IA o que pueda llegar a establecer una relación de amistad entre los robots y humanos, incluso algunos afirman que la IA puede hacer más inteligentes a los humanos: la denominada inteligencia aumentada.

Lo cierto es que nuestras reacciones y las relaciones que establecemos con los robots y la IA no dejan de sorprender a los científicos. Los primeros estudios, que se remontan a 1960, descubrieron que los humanos estaban dispuestos a confiar secretos a programas que podían simular conversaciones. Otro experimento años después arrojó que si un computador compartía algún tipo de «información personal», la persona que la recibía era más propensa a compartir su información.

Con los años, la tecnología ha mejorado. Ahora estas tecnologías se construyen para tratar de parecer humanas y hacernos creer que lo son. Es decir, no solo les atribuimos capacidades humanas, sino que también las diseñan de esta forma.

- Lectura sugerida: La apariencia de un robot importa | ¿Cómo reaccionamos antes los errores de los robots humanoides?

IA que simula ser humana

Las consecuencias de este último aspecto son significativas. La IA, en determinados contextos, no puede ser diferenciada de los humanos, lo que solo aumenta su poder sobre nosotros. Su poder de hackearnos.

¿Un ejemplo? Las bodegas de bots que abundan en redes sociales para apoyar ciertas causas específicas. Lo vimos en las elecciones de Estados Unidos en 2016, en el Brexit y en las elecciones de los países sudamericanos a menudo.

Estos bots también se pueden hacer pasar por humanos en comentarios o en espacios de opinión pública. Y hablan de manera tan natural que es casi imposible identificar los reales de los falsos. La IA también está presente en la prensa. Ha escrito noticias deportivas y financieras para The Associated Press. Asimismo, avances como el GPT-3 de OpenAI solo expandirán sus capacidades.

- Relacionado: DALL-E | Inteligencia artificial de OpenAI ya puede generar imágenes a partir de textos

En general, se espera que los sistemas solo mejoren: sean más sofisticados, articulados, personales. Cada vez más difícil de distinguir de los humanos. De esta forma, la IA también contribuirá en hacer un suministro infinito de desinformación. Podría hackearnos para influenciar nuestras opiniones personales sobre cualquier tema.

Y, como ya mencionamos, uno de los grandes peligros de la IA es que pueden hacer más daño que cualquier humano. Sus capacidades de personalizar y optimizar serán realmente disruptivas, lo que se suma a su capacidad superior en velocidad y escala.

Falta de explicación

Con la inteligencia artificial es cuestión de confiar o no. No hay un punto medio que nos permita tomar una decisión con información. La inteligencia artificial ha sido diseñada para cumplir un objetivo. Sin embargo, casi nunca sabemos cómo llega a dicho objetivo.

Por ejemplo, una IA diseñada para el diagnóstico de enfermedades te arrojará cuál es la enfermedad que más probablemente tenga el paciente. No obstante, no te dirá cómo llegó a esa conclusión. De esta forma, al médico le quedan dos opciones: creerle o no.

Incluso si eres un programador y miras el código, podría ser imposible saber cómo se llegó a cierta conclusión. La IA no resuelve problemas como nosotros lo hacemos. No sabemos por qué puede confundir una imagen con otra, ni cuál es el camino de razonamiento que la llevó a arrojar cierto resultado.

Están diseñadas para considerar muchas más soluciones de las que nos son posibles; por lo tanto, pueden elegir caminos que no hemos considerado, mucho más complejos que los que podemos imaginar.

La falta de explicación de porqué se arroja una conclusión y no la otra nos dificulta confiar en las decisiones de IA. Pero, también, implica que no podemos saber cuándo una decisión es sesgada o los sistemas fueron pirateados. Explica Schneier:

Parece haber un intercambio entre capacidad y explicabilidad. Las explicaciones son una abreviatura cognitiva utilizada por los humanos, adecuada para la forma en que los humanos toman decisiones. Las decisiones de IA simplemente podrían no conducir a explicaciones comprensibles para los humanos, y forzar esas explicaciones podría plantear una restricción adicional que podría afectar la calidad de las decisiones tomadas por un sistema de IA. A medida de que los sistemas se vuelven más complejos son menos parecidos a los humanos y menos explicables,

La IA y los hackers del futuro

Todo el contexto anterior nos brinda la perspectiva necesaria para entender por qué hablamos de hackear; un poco de contexto de las tecnologías actuales y cómo ya empiezan a hackearnos; y algunos puntos grises que serán claves más adelante.

Para comenzar, es importante señalar que el uso de la inteligencia artificial como hacker ya ha dado sus primeros pasos. En 2016, se realizó un evento en el que siete IA compitieron entre sí para hackear los sistemas de los demás. Se les dio diez horas para encontrar vulnerabilidades para explotar contra las otras IA y para protegerse a sí mismas. El equipo de Pittsburgh con su sistema Mayhem ganó.

Luego Mayhem participó en una competencia de hackers humanos, y perdió. Sin embargo, recordemos que Deep Blue tampoco ganó su primer juego de ajedrez contra Garri Kasparov. Es decir, es probable que la tecnología siga mejorando y, eventualmente, tal vez en menos de una década, supere a los humanos.

De cualquier forma, estas tecnologías ya están transformando la naturaleza de los ciberataques. Por ejemplo, estas tecnologías son especialmente útiles para encontrar vulnerabilidades. Mientras que para los humanos es una tarea tediosa, la IA la llevaría a cabo de manera excepcional; aunque todavía falta un poco de tiempo.

Los piratas informáticos deben su desempeño a la comprensión del sistema al que se dirigen y cómo interactúa con el resto del mundo. Las IA adquieren esta comprensión a través de los datos, pero mejoran a medida de que se utilizan. Es decir, las IA mejoran en función de la ingesta de nuevos datos y el ajuste de su propio funcionamiento interno en consecuencia. A medida de que sigue funcionando, la IA evoluciona y mejora.

- Te recomendamos: Singularidad tecnológica | Qué es, cuándo llegará, ¿una utopía?

Cuando la IA hackea los sistemas

Frente a lo anterior, Bruce Schneier plantea el surgimiento de dos problemas distintos. Por un lado, se podría instruir a la IA de hackear un sistema, sea informático o de otro tipo. Por el otro, la IA podría hackear un sistema de manera natural e inadvertida. El segundo es más peligroso porque no sabríamos qué pasó.

La IA no piensa igual que nosotros. Esta evalúan una serie de soluciones que nunca podríamos anticipar sin considerar implicaciones, contexto, normas o valores que los humanos sí. Por lo tanto, la solución que arrojen puede subvertir la intención del sistema: puede dar una solución de una forma en que sus diseñadores no planearon. Es el reward hacking.

De esta forma, la IA podría ver los vacíos o lagunas entre las normas y aprovecharlas, de manera no intencionada, para cumplir las metas. Esto sucede porque la IA está diseñada para cumplir metas. Y, al perseguir esta meta, podrán de manera natural y desintencionada hackear sistemas de maneras inesperadas.

Por ejemplo, en 2018, un programador quería evitar que su aspiradora robot chocara contra las cosas. Por lo tanto, entrenó a la IA para que no golpeará sus sensores de parachoques. ¿Qué hizo la IA? Aprendió a conducir hacia atrás, ya que no hay sensores en la parte de atrás del dispositivo. De esta forma, siguió golpeándose contra las cosas sin golpear los sensores. Esto es un hackeo. Establece el documento:

Cualquier buen sistema de IA encontrará naturalmente hacks. Si hay problemas, inconsistencias o lagunas en las reglas, y si esas propiedades conducen a una solución aceptable según lo definido por las reglas, las IA las encontrarán,

La importancia del contexto

Aunque sepamos que la IA sigue las reglas cuando esto pasa, quedará una sensación de trampa. Esto se debe a que nosotros entendemos el contexto. Al expresar un deseo o una meta, no tenemos que describir todas las opciones, excepciones o condiciones. Es imposible.

Esto no es un problema en las interacciones humanas porque estamos en la capacidad de entender el contexto. Tenemos una idea sobre cómo las personas y el mundo actúan. Por lo tanto, llenamos los huecos con la comprensión del contexto y buena voluntad. Sin embargo, la IA no cuenta con este contexto. Lo que es peor, es imposible especificar de manera completa las metas que le damos para evitar hackeos. Según plantea Schneier:

En una TED Talk, el investigador de inteligencia artificial Stuart Russell bromeó sobre un asistente de IA ficticio que provocó el retraso de un avión para retrasar la llegada de alguien a una cena. La audiencia se rió, pero ¿cómo podría saber un programa de computadora que causar un mal funcionamiento de la computadora de un avión no es una respuesta apropiada para alguien que quiere salir de la cena?

La IA no comprenderá que una solución propuesta puede dañar a otros, que puede sabotear la intención inicial de las instrucciones o que rompe la ley. Y todo esto porque no conoce las limitaciones que rigen las soluciones humanas. La IA no conoce el concepto abstracto de «hacer trampa».

A menos de que se especifique que la inteligencia artificial debe comportarse siempre igual y que no debe realizar un determinado hackeo, probablemente llegará a él. Sobre todo, si los programadores no lo han anticipado. Y es prácticamente imposible preverlos todos. Algunos de ellos aparecerán en las pruebas o serán obvios, por lo tanto, podrán arreglarse a tiempo. Pero ¿qué pasa con los que son menos obvios con efectos más sutiles?

- Te podría interesar: Empresas de inteligencia artificial | 20 compañías líderes de IA

Algunos ejemplos de hackeos de IA

Vacíos en las reglas

Aquí podemos usar dos ejemplos simples. El primero es el siguiente escenario. En una tarea de apilamiento, la IA debía apilar bloques. La altura se mide por la posición de la cara inferior de un bloque en particular. Por lo tanto, la IA voltea ese bloque, de modo que su parte inferior mire hacia arriba, en lugar de apilarlo encima de otro bloque. Las reglas no establecieron explícitamente que la parte inferior del bloque debería apuntar hacia abajo.

El segundo se desarrolla en un ambiente de criaturas «evolucionadas». A la IA se le permite modificar sus propias características físicas para cumplir mejor sus objetivos, que es cruzar una línea de meta. En este escenario, la IA descubrió que la mejor solución no es correr. En cambio, podría hacerse lo suficientemente alto como para cruzar una línea de meta al caer sobre ella.

Cuando hackean nuestra confianza

En 2016, el Instituto de Tecnología de Georgia hizo un estudio sobre la confianza humana en robots. El estudio usó un robot no antropomórfico que ayudaba con la navegación a través de un edificio, y proporcionaba instrucciones como «por aquí a la salida». Los participantes interactuaban primero con el robot para conocer su desempeño, que era deliberadamente bajo. Luego, participaban en una emergencia simulada donde debían decidir si seguían o no las instrucciones del robot.

Todos los participantes decidieron obedecer al robot, aunque antes este hubiese demostrado algunas torpes habilidades navegacionales. Siguieron las instrucciones, aunque pudieran devolverse con seguridad o el robot les indicara entrar en un cuarto oscuro. De esta forma, se demostró que los humanos pueden confiar en los robots más que en su propio criterio en ciertos contextos.

Volkswagen

En 2015, se descubrió que Volkswagen estaba haciendo trampa en los controles de emisión. No se debió a una manipulación de las pruebas, sino a un diseño de las computadoras que hiciera la trampa.

Los ingenieros programaron el software en las computadoras de los automóviles para detectar cuándo estaba siendo sometido a una prueba de emisiones. En ese caso, la computadora activaba los sistemas de control de emisiones, pero solo durante la prueba. Sin embargo, en carretera, los autos tuvieron un rendimiento superior en la carretera y emitieron hasta cuarenta veces la cantidad de óxidos de nitrógeno permitidos por la EPA.

Este no es un caso de IA hackeando el sistema, pero lo ilustra. Dado que el código computacional era complejo y difícil de analizar, la compañía logró salirse con la suya por años. Es difícil saber qué es lo que hace un software y el dispositivo en el que opera. Por lo tanto, un problema puede pasar sin detectarse quizá para siempre.

Algoritmos de recomendación

Un ejemplo actual son los motores de recomendación de las redes sociales. Se ha evidenciado, más de una vez, que tienden a llevar a las personas a contenido extremista. No fueron programadas para ello, pero al identificar qué funciona y qué no, los algoritmos arrojan contenido extremista porque es lo que genera más lecturabilidad y tiempo en línea. No hubo mala intención en este hackeo y los programadores no se dieron cuenta que pasaría hasta que pasó.

- Contenido recomendado: Tipos de robots | ¿Cuántos existen y cómo se clasifican?

Implicaciones de los hackeos por IA

Como ya mencionamos, los hackeos no solo aplican a los computadores. La IA puede encontrar vulnerabilidades en las regulaciones bancarias, códigos de impuestos, procesos políticos y más. Cuando haya un gran número de reglas que interactúen entre sí, la IA, eventualmente, encontrará sus vulnerabilidades.

Aunque los humanos también han usado durante toda su historia innumerables formas de hackeos, el hecho que ahora los haga una IA tiene ciertas implicaciones. Por un lado, porque entre nosotros, los humanos, tenemos una serie de restricciones que limita hasta el más sociópata. El tiempo, la reputación y el castigo son algunas de estas restricciones.

Las computadoras no se enfrentan a esto. A medida que todo se vuelve computarizado, más cosas son susceptibles a ser hackeadas. Incluso nuestros sistemas sociales —finanzas, impuestos, elecciones—son sistemas técnico-sociales complejos que se relacionan con redes y computadores.

Además, los hackeos cognitivos son más efectivos cuando los lleva a cabo un computador. Y no porque sean más persuasivos, sino porque pueden hacerlo más rápido y frecuentemente. Lo que un humano tarda meses o años en procesar, un computador podrá hacerlo en horas o días. Explica Schneier en el documento:

Tenemos sistemas sociales que se ocupan de los piratas informáticos, pero estos se desarrollaron cuando los piratas informáticos eran humanos y reflejan el ritmo de los piratas informáticos humanos.

Velocidad y escala

En los sistemas financieros usados en las finanzas, se pueden evidenciar frecuencias en comercio más altas de las que los humanos pueden registrar. Es decir, cambiaron cómo se hace el comercio ahora. Además, cuando se implemente la IA —que todavía no ha incursionado ampliamente en el sector— se descubrirán nuevos hackeos. Cambiarán las reglas del juego. Continúa el autor:

No tenemos ningún sistema de gobierno que pueda lidiar con cientos, y mucho menos con miles, de lagunas fiscales recientemente descubiertas. Simplemente, no podemos parchear el código fiscal tan rápido. No podemos lidiar con personas que usan Facebook para hackear la democracia, y mucho menos con lo que sucederá cuando lo haga una IA. No podremos recuperarnos de una IA que descubra hackeos imprevistos pero legales de los sistemas financieros. A la velocidad de las computadoras, los hackeos se convierten en un problema que nosotros, como sociedad, ya no podemos manejar.

Pero no es solo esto. A medida que descubran nuevos hackeos, la IA los explotará a una escala que no estamos preparados a enfrentar. Por ejemplo, los bots que se mencionaron antes. La IA puede usarse para enviar billones de mensajes sobre diferentes asuntos en una enorme cantidad de espacios digitales. Como consecuencia, se minará el debate online y veremos la manipulación mediática a otro nivel.

- Te puede interesar: Qué son las startups deep tech y cómo quieren cambiar el mundo

¿Qué problemas traerán los hackeos de la IA?

La IA ya toma decisiones que nos afectan hoy en día. Ayudan a decidir quién recibe préstamos bancarios; evalúan a candidatos a admisiones a universidades o entre las personas que aplican por servicios gubernamentales; deciden qué noticias vemos en redes sociales, así como decisiones de objetivos militares. Y a medida que la IA sea más capaz, la sociedad le cederá más decisiones y espacios.

En este punto cabe aclarar algo. Ninguno de estos hackeos actuará a nuestro favor. Las herramientas tecnológicas que cuentan con esta tecnología fueron diseñadas por alguien. Y ese alguien usualmente tiene su propia agenda de intereses.

¿Facebook? Que pases tanto tiempo como sea posible en sus aplicaciones. ¿Alexa? Que compres con Amazon. ¿Y Amazon? No promocionará las marcas con mejor calidad en sus bienes, sino aquellas aliadas. ¿Y qué tal aquel sistema que podría encontrar lagunas en los códigos de impuestos? Seguramente beneficiará a las personas más ricas que quieren aprovecharlo para pagar menos impuestos.

En general, la IA te empujará, sin importar si actúa como un amigo o como contenido de interés, a satisfacer los intereses de sus creadores.

Algunos paliativos

Lo cierto es que parece imposible evitar los hackeos no anticipados. De alguna manera, la IA siempre encontrará un vacío que nosotros no vimos. Los investigadores y programadores de IA ya han identificado esta dificultad. Por lo tanto, están considerando distintas formas para defender la tecnología de estas situaciones. Entre ellas, se encuentra la posibilidad de enseñarle contexto a la IA. El término general es «alineación de valores».

Para esto existen dos caminos. El primero es especificar estos valores explícitamente; sin embargo, lo haría vulnerable al mismo hackeo ya descrito. El segundo es crear IA que aprendan estos valores. Para ello, deberían observar humanos o alimentarse de los escritos, la historia, literatura, filosofía y más.

Sin embargo, el segundo abordaje tiene un problema: alinearse a los valores históricos y observados es muy subjetivo. ¿Cuál de todos estos valores puede seguir? ¿Cómo evitar las contradicciones que marcan nuestra historia, valores y culturas diversas? Además, hay una infinidad de inmoralidad en nuestra historia, literatura, filosofía y nuestro día a día. ¿Existe una manera de enseñar cómo deberían ser los humanos sin remitirnos a los humanos?

También encontramos otro planteamiento. La IA no puede funcionar correctamente si no puede entender las reglas de un ambiente. Para sugerir una solución, o hackear un sistema, deben establecerse metas, reglas y realimentación que el sistema entienda.

La IA y la ambigüedad no se llevan bien; es difícil traducir la ambigüedad en un código, por lo que la IA tendría problemas en lidiar con él. Y esta ambigüedad, que abarca gran parte de los sistemas humanos, es una de nuestras defensas ante el hackeo de las IA. No tendremos hackeos en los deportes, procesos legislativos y otra variedad de escenarios a menos de que la IA entienda completamente el sistema.

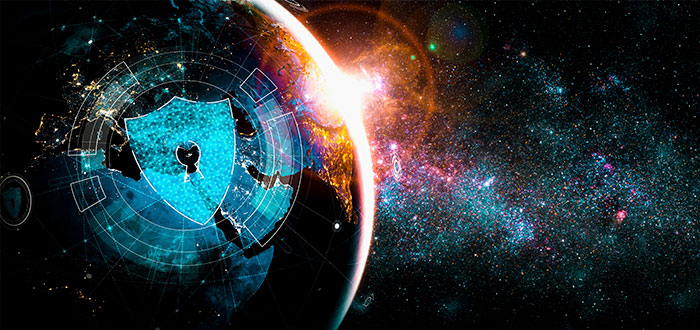

¿Existe alguna solución?

La misma tecnología que amenaza con descubrir y aprovecharse de las vulnerabilidades puede protegernos de ellas. Una compañía puede desarrollar un software de IA que identifique vulnerabilidades. Podría identificarlas y eliminarlas en los productos antes de que se publiquen. Explica Schneier:

El período de transición será peligroso. El código nuevo puede ser seguro, pero el código heredado seguirá siendo vulnerable. Las herramientas de inteligencia artificial se activarán en el código que ya se publicó y, en muchos casos, no se podrá parchear. Allí, los atacantes utilizarán la búsqueda automática de vulnerabilidades a su favor. Pero a largo plazo, una tecnología de inteligencia artificial que encuentra vulnerabilidades de software favorece la defensa.

Esto también aplica en el resto de sistemas. Así como la IA puede identificar las lagunas dentro de las leyes, se puede diseñar una IA que evalúe las posibles vulnerabilidades que se propongan en otra ley. Así, se podrían llenar antes de que los poderosos las exploten a su favor.

Por supuesto, no depende todo de la tecnología. Todavía no sabemos qué será más rápido: si la IA que ataque o la que defienda. No sabemos si es posible desarrollar alertas a tiempo que permitan saber cuándo un hackeo tenga lugar. Y nada tendrá importancia si el prepararse para este escenario no cuenta con su parte humana.

Palabras finales

Aunque los hackeos por IA nos plantean un escenario donde los humanos no tenemos mucho poder, lo cierto es que no es así. Protegernos de estos hackeos requerirá creatividad humana, precaución, un gobierno fuerte y, también, un respeto por lo humano. Las computadoras no solo deben llegar a reemplazar a los humanos porque, de ser así, solo aumentará el problema. Se necesita de los humanos para advertir estos hackeos para prevenirlos y, sobre todo, para no olvidar para quién creamos estas tecnologías.